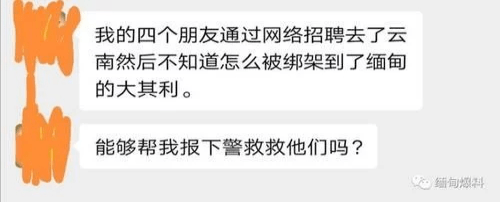

近日,一位拥有百万粉丝的女网红爆出“AI换脸”事件。 这位女网红表示,她的视频评论区突然挤满了人,说看过她的“视频”,但她从来没有发过这样的视频。

她狐疑地打开视频,却发现里面的女孩长得一模一样,却在做着一些难以形容的动作,这让她感到非常愤怒和无奈。 然后她意识到她的脸可能被人工智能(AI)偷走了。

AI技术发展迅猛,最近爆发的AI换脸,不知道你玩过没有。

您只需提供一张有脸的照片,就可以将自己替换成视频或电视剧中的男(女)主角,逼真度非常高,没有任何违和感。

有人把鹿晗的脸换成刘亦菲饰演的“小龙女”这个角色,就是下面的效果。 如果不是之前看过《神雕侠侣》,我还以为是我呢。

AI诈骗的常见手段

第一:声音合成

骗子通过骚扰电话录音等方式提取某人的声音,在获得素材后合成声音,从而可以用假声音欺骗对方。

案子

某公司财务经理小王接到领导电话,要求立即向供应商转账2万元,并通过电子邮件发送转账信息。 转移的原因是为了避免支付滞纳金。 由于老板的口音非常真实,小王信以为真,不到一个小时就完成了转账,但后来发现自己被骗了。

第二种:AI换脸

面子效应更容易获得对方的信任。 利用AI技术换脸,骗子可以冒充任何人,然后通过视频确认信息。 真是防不胜防啊! 诈骗者首先分析公众在互联网上发布的各种信息,并根据要进行的欺骗行为,利用AI技术筛选目标人群。 使用人工智能在视频通话中换脸以获得信任。

案子

近日,小丽的大学同学通过QQ向她借钱。 对方打了四五秒的视频电话,小李见确实是他,就放心地转了3000块钱。 但在第二次转账时,她感觉异常,于是再次给对方打电话,才得知同学的账号被盗,于是她向警方报了案。 警方判断,视频很可能被篡改。

第三种方法:转发微信语音 微信语音也可以转发,这个操作简单! 骗子盗取微信账号后,向好友“借钱”。 为了取得对方的信任,他们会转发之前的声音,然后骗取钱财。 虽然微信没有语音转发功能,但他们通过提取语音文件或安装非官方版本(插件)来实现语音转发。

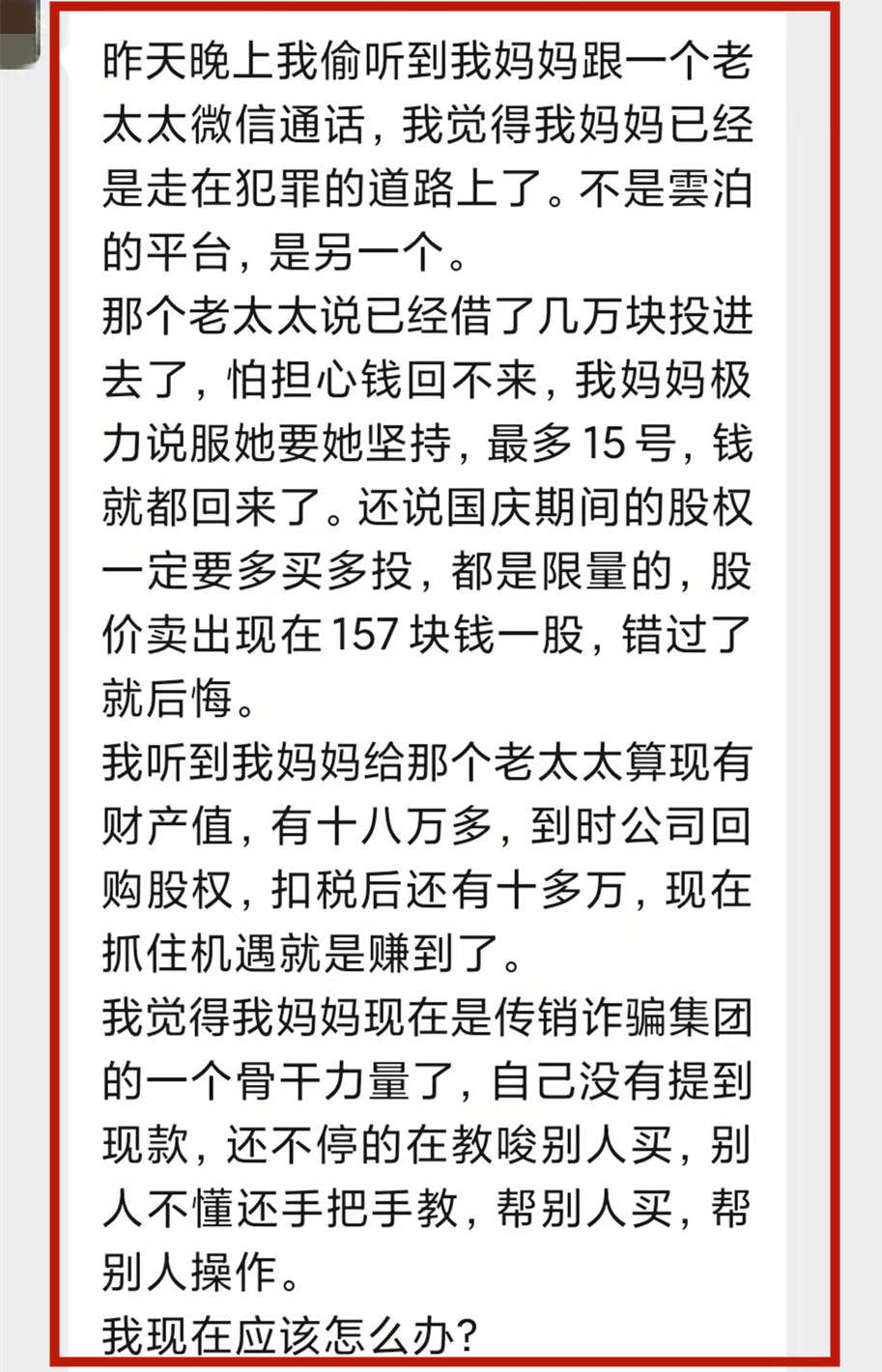

第四种:利用AI技术甄别受骗人群 骗子并不是漫无目的地撒网,而是别有用心地针对特定对象。 他们根据要实施的欺骗来筛选人群来选择目标。 举个栗子:在进行金融诈骗时,经常收集投资信息的小伙伴就会成为他们的潜在目标。 利用AI技术,再加上套路和脚本的解读,这样的诈骗手段你们能守得住吗?

如何预防呢?

面对AI人工智能等新手段进行诈骗,我们必须牢记以下几点:

多重身份验证以确认身份

01

涉及到转账交易等行为时,朋友们要特别注意,可以通过电话、视频等方式确认对方是否是你,当无法确认对方身份时,可以设置到达时间如“2小时到达”或“24小时到达”以预留处理时间。 尝试通过电话询问具体信息,以确认此人是否亲自到场。 即使对方使用AI技术作弊,也可以通过提问进一步确认身份。 建议您转账至对方银行账户,避免通过微信等社交软件转账。 一方面有利于验证对方身份,另一方面也有利于后续转账信息。

保护信息,避免诱惑

02

加强个人信息保护意识,朋友们应谨防各类信息泄露,无论是在互联网上还是社交软件上,尽量避免过多暴露自己的信息。 警惕不明平台发送的广告、赢奖、交友等链接,不要随意填写个人信息,以免被骗子“精准猎杀”。

互相提醒,共同预防

03

这些高科技的诈骗手段让很多朋友感到困惑。 舒莉警官还提醒大家,提醒、警示身边的亲友,提高安全意识和应对高科技诈骗的能力,防止一起上当受骗。 做好居家老人的宣传预防工作。 提醒老人接到电话或短信时放下手机,再次给家人打电话确认,不要贸然转账。

抵制诱惑,保持警惕

04

朋友要学会拒绝诱惑,保持警惕。 避免占别人便宜的心态,警惕陌生人无缘无故的“献礼”。

如果事先不知道骗子的这些伎俩,被骗的可能性就很大。 再次:

你还没有被骗,不是因为你有多聪明,也不是因为你没有钱,而是适合你的“剧本”还在路上。